一转眼从鸡年进入到狗年啦,要说微信上、QQ上最热门的话题是啥?不是年夜饭吃了什么山珍海味,也不是初一凌晨放了多少烟花,而是红包、红包、红包!

(图源 :pixabay)

话说微信群里朋友太能抢了,有一个五百人的群,每次100个红包,都是几秒钟抢完。每次看到红包出现都倍激动,但是打开后都是提示我红包已抢完,失望了无数次以后,我默默的点了退群按钮。

还好有些朋友间的老微信群,就比较正常了,每次十个二十个的红包,基本也能轮到我。昨晚盯着好几个微信群,抢到了几十块钱的红包,当然也发出去不少,最重要的,就是图个热闹嘛。

既然微信群、QQ群都因红包热闹起来,那么就在STEEMIT上也热闹一下,就在STEEMIT上发些点赞红包吧。

活动规则

- 限华语用户参加

- 在本贴下回复给大家的祝福语(中文)

- 符合规则的将会得到我价值 1 SBD(点赞时)的点赞

- 每个用户可以回复多条,但是只有一条可以收到奖励

- 限前30名

其它说明

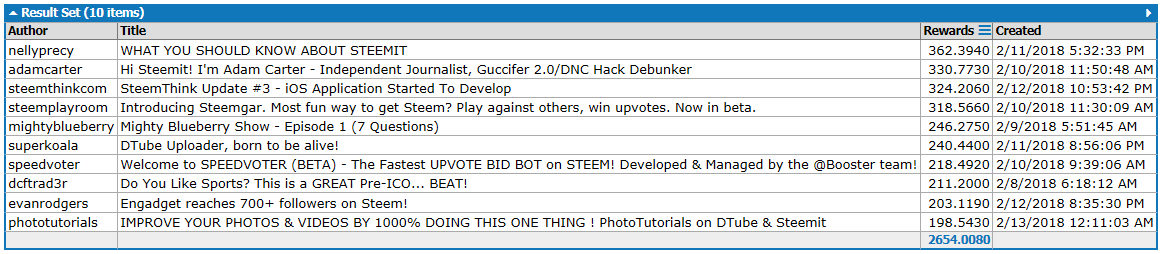

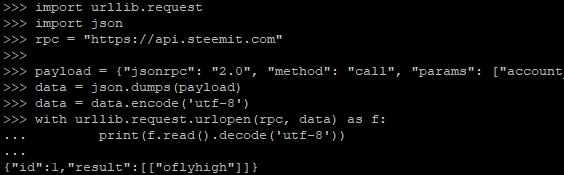

我准备开发给半自动程序帮我计算金额处理点赞,程序还没开工,所以回复可能点的不及时,但是我预计2、3个小时内应该可以写好,大家不要着急😀

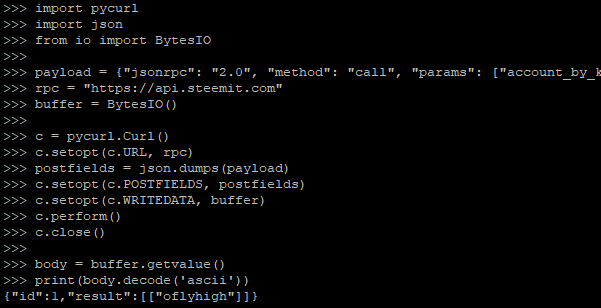

程序的思路和部分代码都现成的,就是通过计算奖励池情况以及我的有效SP和Voting Power,据此计算出我当前的一票能顶出多少SBD。然后换算出,一个SBD需要多少百分比的赞。

我以前弄过一个卖赞小鱼,就是这个思路:《也来试试点赞小鱼,仅仅是测试,限时开放[截止当日(7月12日)北京时间22点],快来玩吧》。但是卖赞小鱼处理的是用户给我转款,与这次点赞红包放送方式不一样,嗯,我改成监控我某个id,然后跟点比较好。

1 SBD并不多,大家热闹热闹,图个开心。

在这祝大家新春大吉,万事如意啊。好了,不多说啦,开始啦,我也要去弄程序去啦。

(图源 :pixabay)

This page is synchronized from the post: 新春大吉! 发祝福,1 SBD点赞红包放送 (共30 SBD) / 活动圆满结束 😀